當(dāng)前位置:首頁 > 學(xué)習(xí)資源 > 講師博文 > 多模態(tài)大模型(VLMM)中的跨模態(tài)對齊損失函數(shù)設(shè) 計與微調(diào)策略

多模態(tài)大模型(VLMM)中的跨模態(tài)對齊損失函數(shù)設(shè) 計與微調(diào)策略

時間:2025-05-09 來源:華清遠(yuǎn)見

多模態(tài)大模型(VLMM)中的跨模態(tài)對齊損失函數(shù)設(shè) 計與微調(diào)策略

時間:2025-05-09 來源:華清遠(yuǎn)見

1 引言

隨著人工智能技術(shù)的快速發(fā)展 ,多模態(tài)大模型(Vision-Language Multi modal Models, VLMM)已成為當(dāng)前研究的熱 點。這類模型能夠同時處理和理解視覺與語言信息 ,在圖像描述生成、視覺問答、跨模態(tài)檢索等任務(wù)上展現(xiàn)出強(qiáng)大 能力。然而 ,如何有效地對齊不同模態(tài)的表示空間 ,仍然是提升模型性能的關(guān)鍵挑戰(zhàn)。本文將深入探討VLMM中的 跨模態(tài)對齊損失函數(shù)設(shè)計與微調(diào)策略。

2 跨模態(tài)對齊的核心挑戰(zhàn)

多模態(tài)學(xué)習(xí)面臨的核心問題是如何讓來自不同模態(tài)(如圖像和文本)的表示在同一個語義空間中保持一致。具體挑戰(zhàn) 包括:

1. 模態(tài)鴻溝:視覺和語言數(shù)據(jù)具有完全不同的統(tǒng)計特性

2. 語義不對齊:相同概念在不同模態(tài)中的表達(dá)方式和抽象層次不同

3. 數(shù)據(jù)規(guī)模差異:視覺和文本數(shù)據(jù)的可用量通常不匹配

3 主流跨模態(tài)對齊損失函數(shù)設(shè)計

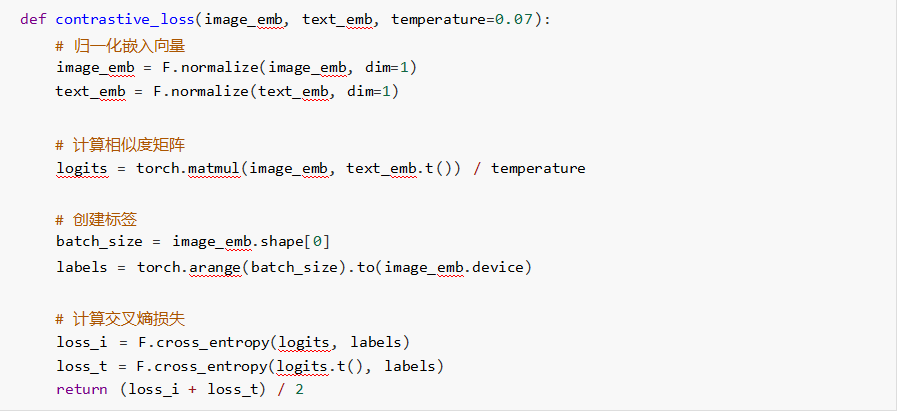

1. 對比學(xué)習(xí)損失(Contrastive Loss)

對比學(xué)習(xí)已成為跨模態(tài)對齊的主流方法 ,其核心思想是拉近正樣本對的表示距離 ,推遠(yuǎn)負(fù)樣本對的表示距離。

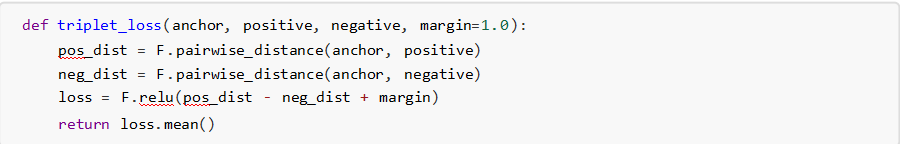

2. 三元組損失(Triplet Loss)

三元組損失通過錨點、正樣本和負(fù)樣本的對比來學(xué)習(xí)跨模態(tài)對齊:

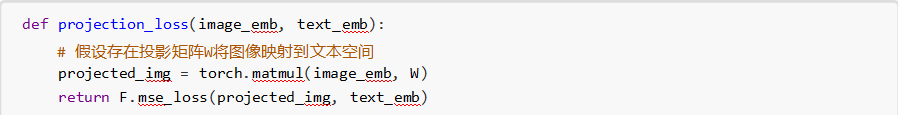

3. 跨模態(tài)投影損失(Cross-Modal Projection Loss)

該方法通過最小化模態(tài)間投影誤差來實現(xiàn)對齊:

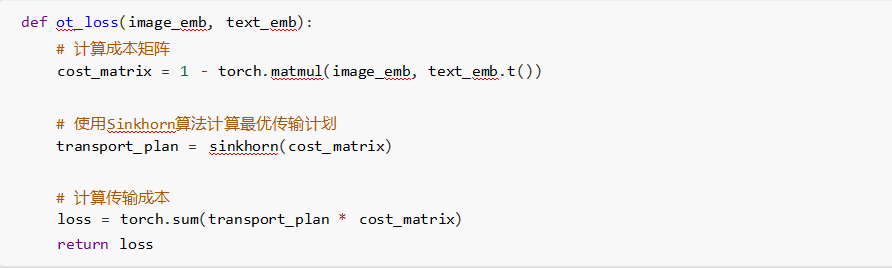

4. 基于最優(yōu)傳輸?shù)膿p失(Optimal Transport Loss)

利用最優(yōu)傳輸理論來建模模態(tài)間的分布對齊:

4 高級對齊策略

1. 層次化對齊(Hierarchical Alignment)

在不同抽象層次上實施對齊約束:

. 局部特征對齊(如圖像區(qū)域與單詞) . 全局語義對齊(如圖片整體與句子)

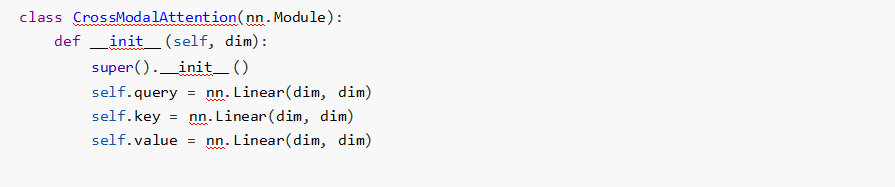

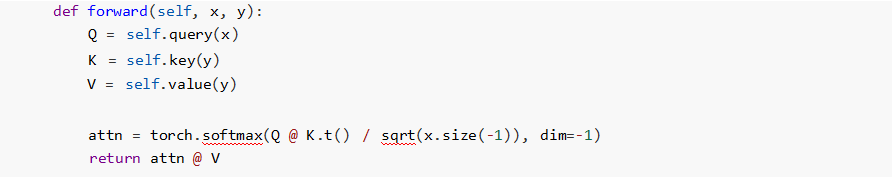

2. 注意力引導(dǎo)對齊(Attention-Guided Alignment)

利用跨模態(tài)注意力機(jī)制發(fā)現(xiàn)模態(tài)間的細(xì)粒度對應(yīng)關(guān)系:

'

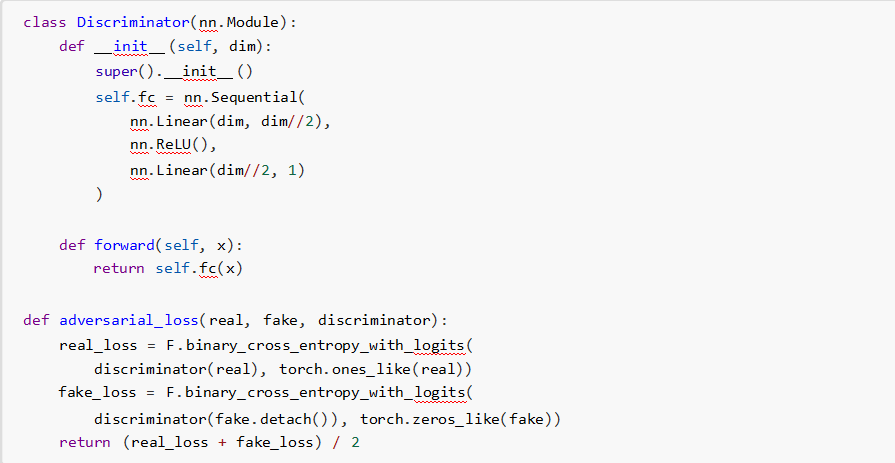

3. 對抗對齊(Adversarial Alignment)

引入判別器網(wǎng)絡(luò)促使兩種模態(tài)的表示難以區(qū)分:

5 微調(diào)策略

1. 兩階段微調(diào)

1. 模態(tài)特定微調(diào) :單獨微調(diào)各模態(tài)編碼器

2. 聯(lián)合微調(diào) :固定編碼器或使用較小學(xué)習(xí)率 ,重點優(yōu)化跨模態(tài)交互部分

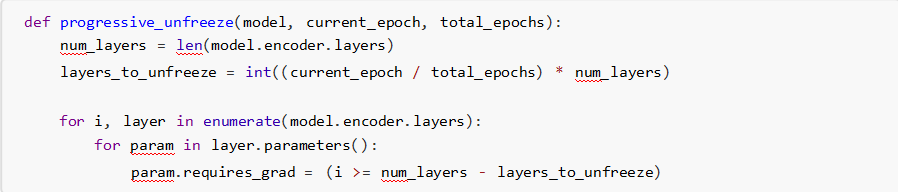

2. 漸進(jìn)式解凍

按照從底層到頂層的順序逐步解凍網(wǎng)絡(luò)參數(shù):

3. 課程學(xué)習(xí)(Curriculum Learning)

從簡單樣本開始 ,逐步增加難度:

先使用高清晰度、簡單背景的圖像 逐漸引入復(fù)雜場景和抽象概念

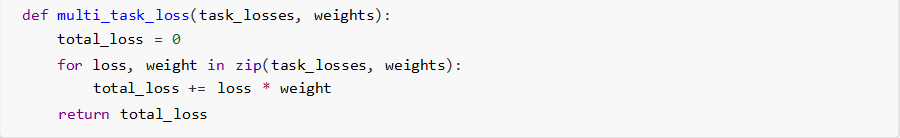

4. 多任務(wù)聯(lián)合學(xué)習(xí)

同時優(yōu)化多個相關(guān)任務(wù):

跨模態(tài)檢索

圖像描述生成 視覺問答

實踐建議

1. 數(shù)據(jù)增強(qiáng):對視覺和文本數(shù)據(jù)實施協(xié)調(diào)的增強(qiáng)策略

2. 溫度參數(shù)調(diào)整:對比學(xué)習(xí)中的溫度參數(shù)需要仔細(xì)調(diào)優(yōu)

3. 負(fù)樣本挖掘:使用難負(fù)樣本(hard negatives)提升對比效果

4. 監(jiān)控指標(biāo) :除了損失值 ,還應(yīng)跟蹤跨模態(tài)檢索準(zhǔn)確率等直接指標(biāo)

未來方向

1. 動態(tài)對齊策略:根據(jù)樣本特性自適應(yīng)調(diào)整對齊強(qiáng)度

2. 無監(jiān)督對齊 :減少對標(biāo)注數(shù)據(jù)的依賴

3. 多模態(tài)知識蒸餾:從小型對齊模型中提取知識

4. 神經(jīng)符號結(jié)合:結(jié)合符號推理增強(qiáng)對齊可解釋性

結(jié)語

跨模態(tài)對齊是多模態(tài)大模型成功的關(guān)鍵。通過精心設(shè)計的損失函數(shù)和微調(diào)策略 ,我們可以有效地橋接不同模態(tài)之間 的語義鴻溝。未來隨著模型規(guī)模的不斷擴(kuò)大和對齊技術(shù)的持續(xù)創(chuàng)新 ,多模態(tài)理解與生成能力將進(jìn)一步提升 ,為人機(jī) 交互和AI應(yīng)用開辟新的可能性。

嵌入式邊緣計算場景下FPGA動態(tài)部分重配置技術(shù)實踐

嵌入式邊緣計算場景下FPGA動態(tài)部分重配置技術(shù)實踐 多模態(tài)大模型(VLMM)中的跨模態(tài)對齊損失函數(shù)設(shè) 計與微

多模態(tài)大模型(VLMM)中的跨模態(tài)對齊損失函數(shù)設(shè) 計與微 嵌入式系統(tǒng)中非易失性內(nèi)存(NVM)的磨損均衡算法設(shè)計

嵌入式系統(tǒng)中非易失性內(nèi)存(NVM)的磨損均衡算法設(shè)計 固件、軟件和硬件在定義、功能和應(yīng)用場景上存在顯著區(qū)

固件、軟件和硬件在定義、功能和應(yīng)用場景上存在顯著區(qū) AI模型蒸餾技術(shù)在微控制器上的內(nèi)存占用與精度平衡實踐

AI模型蒸餾技術(shù)在微控制器上的內(nèi)存占用與精度平衡實踐 《量子機(jī)器學(xué)習(xí)在嵌入式系統(tǒng)中的可行性分析與原型實現(xiàn)

《量子機(jī)器學(xué)習(xí)在嵌入式系統(tǒng)中的可行性分析與原型實現(xiàn) 嵌入式Linux實時性改造:PREEMPT_RT補(bǔ)丁與Xenomai雙核

嵌入式Linux實時性改造:PREEMPT_RT補(bǔ)丁與Xenomai雙核 圖神經(jīng)網(wǎng)絡(luò)(GNN)在物聯(lián)網(wǎng)設(shè)備關(guān)系推理中的應(yīng)用與性能

圖神經(jīng)網(wǎng)絡(luò)(GNN)在物聯(lián)網(wǎng)設(shè)備關(guān)系推理中的應(yīng)用與性能 嵌入式邊緣計算場景下FPGA動態(tài)部分重配置技術(shù)實踐

嵌入式邊緣計算場景下FPGA動態(tài)部分重配置技術(shù)實踐 基于深度學(xué)習(xí)的異常檢測算法在時間序列數(shù)據(jù)中的應(yīng)用

基于深度學(xué)習(xí)的異常檢測算法在時間序列數(shù)據(jù)中的應(yīng)用