AI模型蒸餾技術在微控制器上的內存占用與精度平衡實踐

時間:2025-04-27 來源:華清遠見

AI模型蒸餾技術在微控制器上的內存占用與精度平衡實踐

時間:2025-04-27 來源:華清遠見

在微控制器(MCU)上部署AI模型時,模型蒸餾(Knowledge Distillation) 是平衡模型精度與內存占用的關鍵技術。以下是針對MCU場景的實踐指南,涵蓋技術選型、優(yōu)化策略與代碼示例。

1.模型蒸餾的核心思想

教師模型(Teacher):高精度但復雜的大模型(如ResNet、BERT)。

學生模型(Student):輕量化的精簡模型(如MobileNet、TinyBERT)。

蒸餾目標:通過知識遷移(如輸出概率軟化、中間特征對齊),使學生模型在減少參數量的同時盡可能接近教師模型的性能

2. MCU的硬件限制與應對策略

挑戰(zhàn)

內存限制:通常MCU的RAM為幾十KB至幾百KB,F(xiàn)lash存儲為幾百KB至幾MB。

算力限制:低主頻CPU(如ARM Cortex-M4@100MHz),無專用AI加速器。

功耗約束:需低功耗運行(如電池供電設備)

3. 實踐步驟與代碼示例

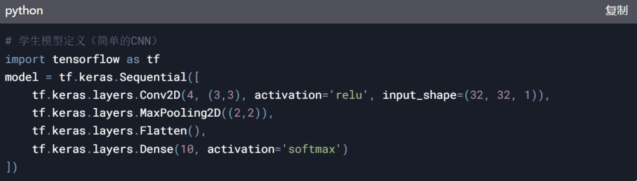

步驟1:設計學生模型

選擇輕量架構:例如適用于MCU的TinyML模型(如MicroNet、TinyConv)。

代碼示例(TensorFlow Lite for Microcontrollers):

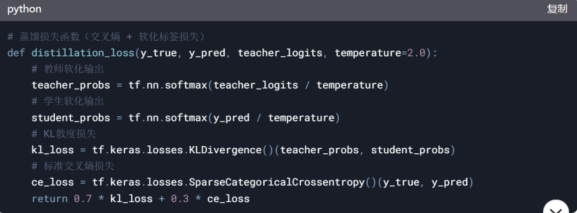

步驟2:蒸餾訓練

損失函數設計:結合教師模型的軟化輸出與學生模型的輸出。

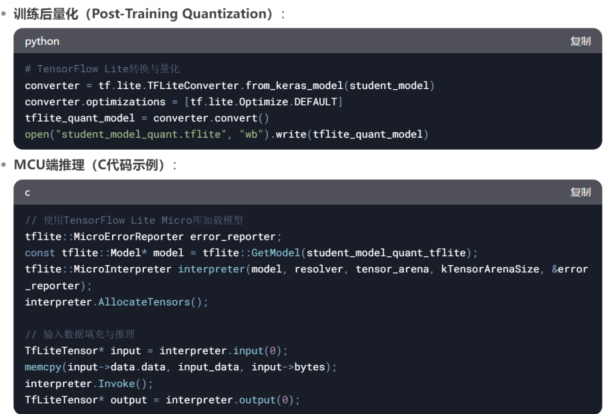

步驟3:量化與部署

訓練后量化(Post-Training Quantization):

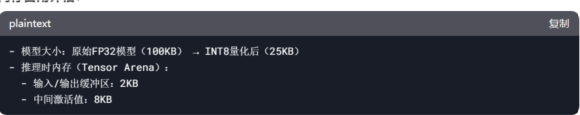

步驟4:內存優(yōu)化分析

內存占用評估:

4. 精度與內存平衡技巧

技巧1:動態(tài)溫度調整

高溫(T=5):訓練初期,軟化教師輸出以傳遞更多知識。

低溫(T=1):訓練后期,逐步恢復真實標簽的權重。

技巧2:選擇性特征蒸餾

僅對齊關鍵層:例如僅對最后一層卷積的特征圖進行L2損失計算,減少計算開銷。

固件、軟件和硬件在定義、功能和應用場景上存在顯著區(qū)

固件、軟件和硬件在定義、功能和應用場景上存在顯著區(qū) AI模型蒸餾技術在微控制器上的內存占用與精度平衡實踐

AI模型蒸餾技術在微控制器上的內存占用與精度平衡實踐 《量子機器學習在嵌入式系統(tǒng)中的可行性分析與原型實現(xiàn)

《量子機器學習在嵌入式系統(tǒng)中的可行性分析與原型實現(xiàn) 嵌入式Linux實時性改造:PREEMPT_RT補丁與Xenomai雙核

嵌入式Linux實時性改造:PREEMPT_RT補丁與Xenomai雙核 圖神經網絡(GNN)在物聯(lián)網設備關系推理中的應用與性能

圖神經網絡(GNN)在物聯(lián)網設備關系推理中的應用與性能 嵌入式邊緣計算場景下FPGA動態(tài)部分重配置技術實踐

嵌入式邊緣計算場景下FPGA動態(tài)部分重配置技術實踐 基于深度學習的異常檢測算法在時間序列數據中的應用

基于深度學習的異常檢測算法在時間序列數據中的應用 嵌入式實時操作系統(tǒng)(RTOS)中時間觸發(fā)與事件觸發(fā)混合

嵌入式實時操作系統(tǒng)(RTOS)中時間觸發(fā)與事件觸發(fā)混合 基于Arm Cortex-M55的微控制器AI指令集擴展與性能調優(yōu)

基于Arm Cortex-M55的微控制器AI指令集擴展與性能調優(yōu) 基于隱式神經表示的3D場景壓縮與實時渲染技術實踐

基于隱式神經表示的3D場景壓縮與實時渲染技術實踐