當(dāng)前位置:首頁 > 學(xué)習(xí)資源 > 講師博文 > 面向邊緣設(shè)備的TinyML模型自動化剪枝與量化聯(lián)合優(yōu)化框架

面向邊緣設(shè)備的TinyML模型自動化剪枝與量化聯(lián)合優(yōu)化框架

時間:2025-05-20 來源:華清遠(yuǎn)見

面向邊緣設(shè)備的TinyML模型自動化剪枝與量化聯(lián)合優(yōu)化框架

時間:2025-05-20 來源:華清遠(yuǎn)見

引言:邊緣計算與TinyML的挑戰(zhàn)

隨著物聯(lián)網(wǎng)(IoT)和邊緣計算的快速發(fā)展,部署在資源受限設(shè)備(如傳感器、攝像頭、可穿戴設(shè)備)上的微型機(jī)器學(xué)習(xí)(TinyML)模型需求激增。然而,這類設(shè)備的計算能力、內(nèi)存和能耗限制,使得傳統(tǒng)的深度學(xué)習(xí)模型難以直接部署。為此,模型壓縮技術(shù)(如剪枝和量化)成為關(guān)鍵手段。但如何自動化實現(xiàn)剪枝與量化的聯(lián)合優(yōu)化,同時平衡模型精度與效率,仍是行業(yè)痛點。

傳統(tǒng)優(yōu)化方法的局限性

傳統(tǒng)模型壓縮通常分兩步走:

1. 剪枝(Pruning):移除冗余的神經(jīng)元或權(quán)重,減少模型參數(shù)。

2. 量化(Quantization):將高精度浮點運(yùn)算(如FP32)轉(zhuǎn)換為低精度整數(shù)(如INT8),降低計算開銷。

然而,這種分階段優(yōu)化存在顯著問題:

· 次優(yōu)解:獨(dú)立優(yōu)化可能破壞模型結(jié)構(gòu),導(dǎo)致精度大幅下降。

· 手動調(diào)參成本高:需反復(fù)實驗剪枝率、量化位寬等超參數(shù)。

· 硬件適配不足:不同邊緣設(shè)備的算力差異大,需定制化優(yōu)化策略。

聯(lián)合優(yōu)化框架的核心思想

針對上述問題,自動化剪枝與量化聯(lián)合優(yōu)化框架應(yīng)運(yùn)而生。其核心目標(biāo)是通過協(xié)同優(yōu)化,在壓縮模型的同時保留關(guān)鍵特征,并自動適配目標(biāo)硬件約束。以下是技術(shù)實現(xiàn)的關(guān)鍵路徑:

1. 多目標(biāo)聯(lián)合搜索

· 搜索空間定義:將剪枝率、量化位寬、層間優(yōu)化策略等參數(shù)納入統(tǒng)一搜索空間。

· 自動化策略:使用強(qiáng)化學(xué)習(xí)(RL)、遺傳算法(GA)或基于梯度的NAS(Neural Architecture Search)動態(tài)探索最優(yōu)組合。

· 硬件感知約束:將設(shè)備的內(nèi)存、延遲、能耗等指標(biāo)作為優(yōu)化目標(biāo),而非僅關(guān)注模型大小。

2. 輕量級評估與反饋

· 代理模型(Proxy Model):通過小型子網(wǎng)絡(luò)模擬原模型行為,加速搜索過程。

· 一次性訓(xùn)練(One-Shot Training):在超網(wǎng)絡(luò)(Supernet)中預(yù)訓(xùn)練所有可能的子結(jié)構(gòu),避免重復(fù)訓(xùn)練開銷。

3. 動態(tài)適應(yīng)性優(yōu)化

· 漸進(jìn)式壓縮:分階段調(diào)整剪枝和量化強(qiáng)度,逐步逼近最優(yōu)解(如從粗粒度剪枝到細(xì)粒度量化)。

· 敏感性分析:自動識別對精度影響大的層,優(yōu)先保留其參數(shù)精度。

典型案例與實驗結(jié)果

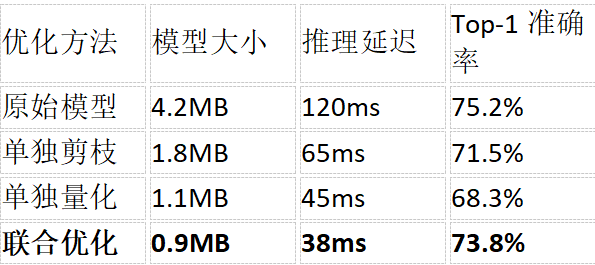

以MobileNetV3在ARM Cortex-M4芯片上的部署為例,聯(lián)合優(yōu)化框架可實現(xiàn)以下效果:

實驗表明,聯(lián)合優(yōu)化在模型大小和延遲降低的同時,精度損失顯著小于分步優(yōu)化。

行業(yè)應(yīng)用與開源工具

目前,聯(lián)合優(yōu)化框架已在以下場景落地:

· 工業(yè)預(yù)測性維護(hù):在MCU上部署異常檢測模型,實時監(jiān)控設(shè)備狀態(tài)。

· 智能家居:低功耗語音喚醒詞識別(如“Hey Siri”)。

· 自動駕駛:車載攝像頭中的輕量級目標(biāo)檢測模型。

主流開源工具推薦:

· TensorFlow Model Optimization Toolkit:支持Keras模型的自動化剪枝與量化。

· NNI(Neural Network Intelligence):微軟推出的自動機(jī)器學(xué)習(xí)工具包,支持多目標(biāo)聯(lián)合優(yōu)化。

· MCUNet:MIT開發(fā)的TinyML框架,專為微控制器設(shè)計。

未來展望

1. 自動化與個性化結(jié)合:針對用戶數(shù)據(jù)分布動態(tài)調(diào)整壓縮策略。

2. 新型硬件協(xié)同設(shè)計:結(jié)合存算一體(In-Memory Computing)等架構(gòu)優(yōu)化模型。

3. 標(biāo)準(zhǔn)化評估體系:建立跨平臺的TinyML模型性能基準(zhǔn)測試。

結(jié)語

在邊緣計算時代,自動化剪枝與量化聯(lián)合優(yōu)化框架正成為TinyML落地的“最后一公里”技術(shù)。通過軟硬件協(xié)同設(shè)計、多目標(biāo)搜索和動態(tài)適應(yīng)性優(yōu)化,我們有望在資源受限的設(shè)備上實現(xiàn)更高效、更智能的AI應(yīng)用。

(本文為技術(shù)綜述,具體實現(xiàn)需結(jié)合業(yè)務(wù)場景調(diào)整參數(shù)與工具鏈。)

嵌入式系統(tǒng)硬件安全:物理不可克隆功能(PUF)密鑰生

嵌入式系統(tǒng)硬件安全:物理不可克隆功能(PUF)密鑰生 面向邊緣設(shè)備的TinyML模型自動化剪枝與量化聯(lián)合優(yōu)化框

面向邊緣設(shè)備的TinyML模型自動化剪枝與量化聯(lián)合優(yōu)化框 嵌入式視覺系統(tǒng)中基于硬件加速的YOLO目標(biāo)檢測算法移植

嵌入式視覺系統(tǒng)中基于硬件加速的YOLO目標(biāo)檢測算法移植 嵌入式設(shè)備固件空中升級(OTA)的安全性與可靠性保障

嵌入式設(shè)備固件空中升級(OTA)的安全性與可靠性保障 嵌入式Linux實時性改造:Xenomai雙核方案與PREEMPT_RT

嵌入式Linux實時性改造:Xenomai雙核方案與PREEMPT_RT 了解自動駕駛的嵌入式視覺SoC中ISP與NPU

了解自動駕駛的嵌入式視覺SoC中ISP與NPU 基于LoRaWAN 2.4GHz的星型拓?fù)渚W(wǎng)絡(luò)抗干擾與頻譜效率提

基于LoRaWAN 2.4GHz的星型拓?fù)渚W(wǎng)絡(luò)抗干擾與頻譜效率提 大語言模型(LLM)中的KV緩存壓縮與動態(tài)稀疏注意力機(jī)

大語言模型(LLM)中的KV緩存壓縮與動態(tài)稀疏注意力機(jī) 基于擴(kuò)散模型的高分辨率圖像生成加速與顯存優(yōu)化

基于擴(kuò)散模型的高分辨率圖像生成加速與顯存優(yōu)化 基于RISC-V向量擴(kuò)展(RVV)的嵌入式DSP算法加速與指令

基于RISC-V向量擴(kuò)展(RVV)的嵌入式DSP算法加速與指令